728x90

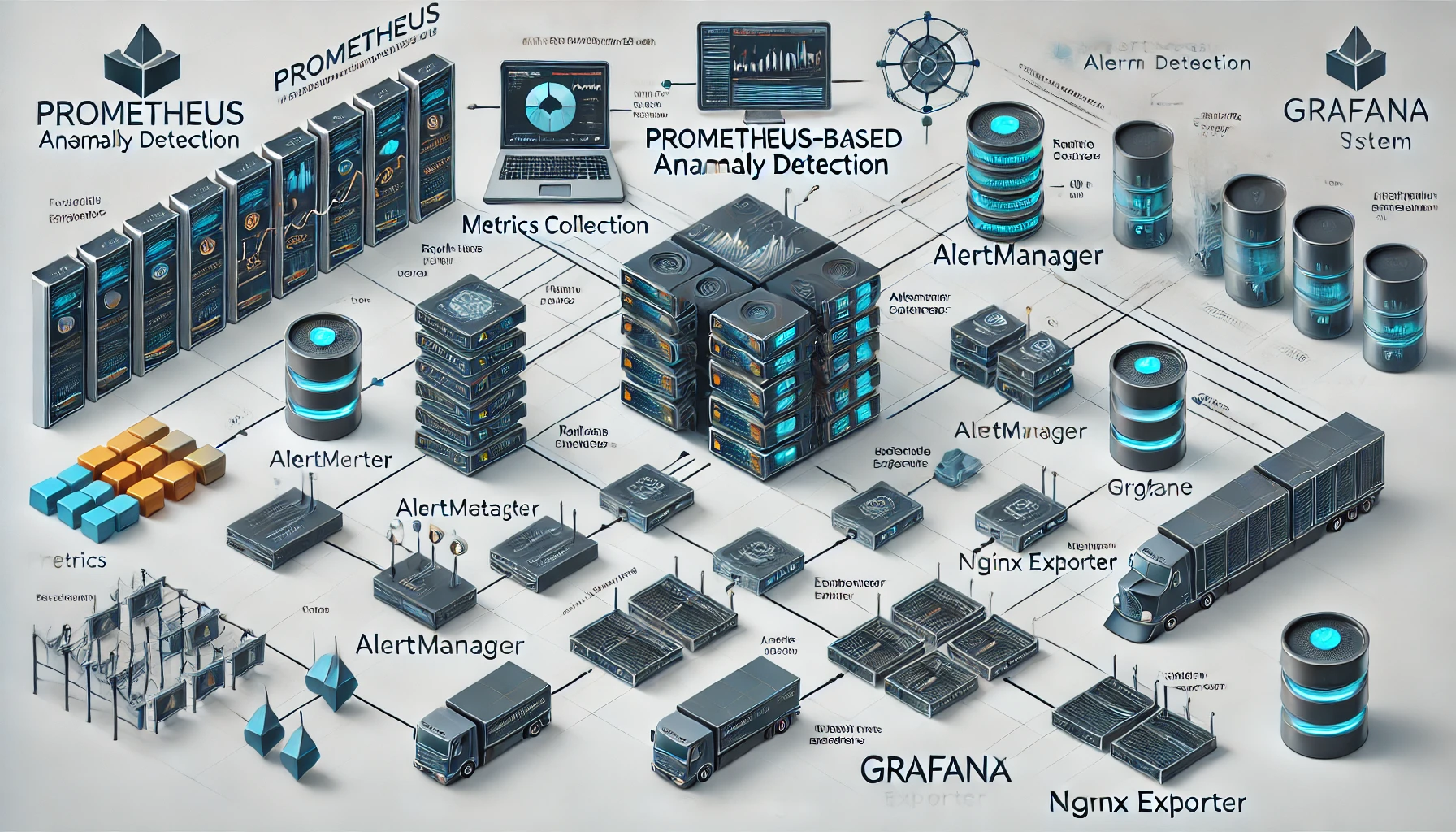

Prometheus를 활용하여 대규모 환경에서 효율적으로 이상 탐지를 수행하기 위한 방법론과 예제입니다. 이를 통해 실시간으로 메트릭을 수집하고 이상 감지를 자동화하여 신속한 대응 체계를 구축할 수 있습니다.

1. Prometheus 이상 탐지의 필요성

- 핵심 목표

- 실시간으로 문제를 탐지하여 서비스 가용성을 유지.

- 대규모 메트릭 데이터를 효율적으로 처리하고 분석.

- 자동화된 알림 시스템으로 운영자의 대응 시간 단축.

- 대규모 환경의 도전 과제

- 데이터 볼륨 증가로 인한 성능 저하.

- 복잡한 패턴과 주기적 이상을 동시에 처리.

2. Prometheus 이상 탐지 시스템 구성

아래와 같은 기본 구조를 기반으로 이상 탐지 시스템을 구성합니다.

- 메트릭 수집: Exporter, Pushgateway, ServiceMonitor 등으로 데이터를 수집.

- Recording Rules: 반복 계산 작업을 줄이기 위해 계산된 값을 저장.

- Alerting Rules: 특정 조건에 따라 알림 생성.

- 시각화: Grafana를 사용하여 상태를 실시간 모니터링.

3. Prometheus 설정 예제

3.1 Recording Rules 설정

Recording Rules를 사용하여 메트릭의 평균, 표준편차 및 이상 감지 범위를 계산합니다.

- 평균 계산

groups: - name: baseline_rules rules: - record: avg_response_time_1h expr: avg_over_time(http_request_duration_seconds[1h]) - 표준편차 계산

- record: stddev_response_time_24h expr: stddev_over_time(http_request_duration_seconds[24h]) - 이상 탐지 범위 계산

- record: upper_band expr: avg_response_time_1h + 3 * stddev_response_time_24h - record: lower_band expr: avg_response_time_1h - 3 * stddev_response_time_24h

3.2 Alerting Rules 설정

정의된 이상 탐지 범위(upper_band, lower_band)를 기준으로 알림을 설정합니다.

groups:

- name: alerting_rules

rules:

- alert: HighResponseTime

expr: http_request_duration_seconds > upper_band

for: 2m

labels:

severity: warning

annotations:

summary: "High response time detected on {{ $labels.instance }}"

description: "Response time is {{ $value }}s, exceeding the upper threshold."3.3 주기적 패턴 처리

시스템에서 발생하는 주기적 이벤트를 처리하기 위해 offset을 사용하여 과거 데이터를 비교합니다.

- record: upper_band_seasonal

expr: avg_response_time_1h offset 24h + 3 * stddev_response_time_24h offset 24h4. Grafana 시각화

- 대시보드 구성

- 현재 값과 상한/하한 값을 동일 패널에 표시.

- 주기적 패턴을 시각화하기 위해 offset 데이터를 추가.

- 템플릿화

- 여러 인스턴스에서 공통적으로 사용할 수 있도록 변수화.

5. PromQL을 사용한 실시간 분석

PromQL을 사용하여 이상 징후를 실시간으로 분석합니다.

- 이상 탐지 표현식

http_request_duration_seconds > avg_over_time(http_request_duration_seconds[1h]) + 3 * stddev_over_time(http_request_duration_seconds[24h]) - 예외적인 응답 비율 탐지

rate(http_requests_total{status="500"}[5m]) / rate(http_requests_total[5m]) > 0.1

6. 운영 중 예상 문제와 해결 방안

- 알림 과다 발생

- 곱셈 계수(

stddev_multiplier)를 조정하여 민감도를 낮춤. for조건으로 알림 발생 지연 설정.

- 곱셈 계수(

- 알림 누락

- 기준 범위를 동적으로 조정하거나 더 긴 관찰 기간을 설정.

- 중요 이벤트를 감지하기 위해 추가 조건 적용.

- 확장성 문제

- Prometheus Federation으로 여러 서버의 데이터를 통합 관리.

7. 자동화 및 최적화

- CI/CD 통합

- Prometheus 설정 파일을 Git으로 관리하고 자동 배포.

- 머신러닝 적용

- 메트릭 데이터를 분석하여 이상 탐지 규칙을 자동 생성.

Prometheus + Thanos를 활용하여 장기 데이터를 학습.

- Alertmanager와 연동

- Slack, 이메일, PagerDuty 등과 통합하여 알림을 유연하게 전달.

8. Prometheus 설정 코드

Prometheus 구성 파일 예제

global:

scrape_interval: 15s

evaluation_interval: 15s

rule_files:

- 'rules/*.yaml'

scrape_configs:

- job_name: 'node_exporter'

static_configs:

- targets: ['localhost:9100']Alertmanager 설정 파일

global:

resolve_timeout: 5m

route:

receiver: 'slack-notifier'

receivers:

- name: 'slack-notifier'

slack_configs:

- api_url: 'https://hooks.slack.com/services/T000/B000/XXXXX'

channel: '#alerts'

send_resolved: truePrometheus를 활용한 대규모 이상 탐지 시스템은 간단한 설정으로도 강력한 기능을 제공합니다. 평균 및 표준편차 기반의 이상 탐지 규칙, 주기적 패턴 처리, Grafana와의 연동을 통해 실시간 이상 탐지와 시각화를 수행할 수 있습니다. 추가적으로, Alertmanager 및 머신러닝 도구와 통합하여 보다 정교한 탐지 및 운영 환경을 구축할 수 있습니다.

728x90

그리드형

댓글